Przyjęło się uważać, że wszystkie bodźce docierające do naszych zmysłów mają charakter analogowy. Oznacza to, że w każdym dowolnym momencie można określić ich konkretną wielkość. Dotyczy to również dwóch najważniejszych zmysłów: wzroku i słuchu. Nasz zmysł słuchu jest ciągle pobudzany zmianami ciśnienia otaczającego nas powietrza. Te zmiany są interpretowane przez nasze mózgi jako wrażenia dźwiękowe. Zmysł słuchu – bardzo istotny dla przetrwania – jest również źródłem wrażeń estetycznych. Rytm i melodia towarzyszą nam od bardzo dawna. Kiedy rozwój nauki i techniki osiągnął odpowiednio wysoki poziom, ludzie zaczęli szukać sposobu na utrwalenie dźwięku i potem jego odtworzenie. Francuz Edward-Leon Scott de Martinville był pierwszym, który zapisał dźwięk na długo przed Edisonem. Jego fonautograf był zbudowany z tuby i membrany. Membrana, pobudzona falami dźwiękowymi, drgała i poruszała rylec dotykający papierowego cylindra. Edison wykorzystał jego prace i skonstruował słynny już fonograf, który zapisywał drgania rylca na aluminiowym walcu. Fonograf pozwalał na zapisywanie i odtwarzanie zarejestrowanego dźwięku. To był początek całej serii całkowicie mechanicznych urządzeń konsumenckich, które pozwalały na odtwarzanie nagrań. W końcowej fazie rozwoju dołączyły do tej grupy patefony z napędem sprężynowym, odtwarzające szybko obracające się płyty z szelaku. Dźwięk był zapisywany w postaci rowka na płaskiej powierzchni, a odtwarzany czysto mechanicznie przez zespół igły z membraną, połączoną z tubą. Płyty gramofonowe przeszły długą drogę rozwoju i nadal są używane z powodzeniem jako źródło wysokiej jakości dźwięku. Oczywiście nowoczesne gramofony nie są urządzeniami czysto mechanicznymi, ale sam proces odczytu odbywa się dalej mechanicznie – tak jak w pierwszych fonografach.

Drugą metodą utrwalania dźwięku jest zapis magnetyczny. W porównaniu z płytą gramofonową ma jedną niezaprzeczalną zaletę: możliwość nie tylko odtwarzania, ale też i wielokrotnego zapisywania materiału dźwiękowego, również w warunkach domowych. Zapis magnetyczny może zaoferować bardzo dobrą jakość dźwięku – w czasach intensywnego rozwoju magnetofonów powstały konstrukcje studyjne o doskonałych parametrach, przeznaczone do zapisywania materiału muzycznego, na podstawie którego tłoczono potem płyty gramofonowe. W obszarze zastosowań konsumenckich magnetofony zajmowały kluczową pozycję. Były obowiązkowym wyposażeniem melomana. Nawet na bardzo ograniczonym nośniku, jakim była kaseta Compact, potrafiono uzyskać satysfakcjonującą jakość zapisywania i odtwarzania.

Jak już wspomniałem, obie te metody dawały konsumentowi możliwość odtwarzania dźwięku na bardzo wysokim poziomie, oczywiście pod warunkiem posiadania urządzeń o odpowiedniej jakości. Obie też bazowały na naturalnym, analogowym sposobie działania. Czy miały jakieś wady? Podstawową była degradacja zapisanego sygnału podczas odtwarzania. Nawet najlepsze płyty gramofonowe ulegają mikrouszkodzeniom w czasie mechanicznego kontaktu igły wkładki z rowkiem płyty. Rozwój wkładek wymagających małych nacisków igły oraz ulepszenie technologii produkcji płyt ogranicza to zjawisko, ale nadal nie można go całkowicie wyeliminować. W magnetofonach następuje natomiast naturalne ścieranie warstwy magnetycznej w czasie jej kontaktu z głowicami i innymi elementami toru przesuwu. Ponadto taśma w trakcie pracy jest rozciągana i ulega częściowemu rozmagnesowaniu, nie można też nie wspomnieć o zużywaniu się samych głowic i mechaniki napędu taśmy.

Dla przeciętnego konsumenta wady te nie miały zbyt wielkiego znaczenia, ale zwolennicy wiernego odtwarzania muzyki borykali się z tym problemem. W latach 70. XX wieku pojawiła się technika, która w założeniu mogła dać bardzo wysoką jakość dźwięku i była, przynajmniej teoretycznie, odporna na degradację w czasie odtwarzania. Technika ta opierała się na konwersji analogowego sygnału audio na postać cyfrową, której materiał audio był zapisywany na płycie i odtwarzany promieniem lasera. Na końcu cyfrowe dane przekształcano na postać analogową. Był to standard płyty Compact Disc. Jeżeli płyta CD nie została uszkodzona mechanicznie, to jakość dźwięku nie zmieniała się, niezależnie od liczby odtworzeń. Żeby zachęcić konsumentów do zakupu nowych odtwarzaczy, użyto sloganów o „krystalicznie czystym dźwięku” i niesamowicie wysokiej jakości nagranej muzyki. Na początku rozwoju standardu CD nie było to prawdą i jakość materiału dźwiękowego ustępowała wyraźnie jakości płyt winylowych i magnetofonów wysokiej klasy. Wpływ na to miały głównie niedoskonałe przetworniki cyfrowo-analogowe. Ostatecznie jednak standard się przyjął i cyfrowa rewolucja stała się faktem, co miało kolosalne znaczenie dla całego rynku muzycznego. Dzisiaj, po wielu latach rozwoju, trudno sobie wyobrazić świat audio bez techniki cyfrowej. Zapewnia ona skalowaną jakość dostosowaną do wymagań konsumenta, bezproblemowe odtwarzanie, ale też zapisywanie materiału na dowolnym nośniku danych cyfrowych. W ostatnich latach kluczowa staje się możliwość przesyłania cyfrowego sygnału audio przez łącza internetowe. Kiedyś podstawowym źródłem sygnału był tuner radiowy, gramofon, magnetofon lub odtwarzacz CD. Teraz tę funkcję przejmuje streamer odtwarzający muzykę przesyłaną przez Internet lub zapisaną na lokalnych nośnikach.

Próbkowanie sygnału analogowego

Jak już wiemy, otaczający nas świat ma naturę analogową – jesteśmy do niego przystosowani ewolucyjnie i dlatego dźwięki do nas docierające muszą być analogowe, co oznacza, że w dowolnie wybranym momencie można określić wartość poziomu natężenia dźwięku, a – po przekształceniu na sygnał elektryczny – także wartość napięcia odpowiadającego temu natężeniu. Jeżeli na wykresie zaprezentujemy czas w osi X, a wartość napięcia w osi Y, to możemy graficznie pokazać zmienność w czasie takiego sygnału – rysunek 1.

Zamiana sygnału analogowego na postać cyfrową nazywa się próbkowaniem i kwantyzacją – polega na mierzeniu analogowej z określoną częstotliwością oraz zapisywaniu jej wartości dyskretyzowanej. Po takiej operacji analogowy sygnał jest reprezentowany przez zbiór liczb – mówimy teraz, że sygnał ma reprezentację dyskretną. Ma to fundamentalne znaczenie, bo same liczby można bez problemu zapisywać w plikach, kopiować bez utraty jakości lub przesyłać dowolnymi łączami cyfrowymi, w tym przez Internet. A to nie koniec, bo możliwa jest kompresja tych danych – połączona z utratą jakości, ale powodująca, że ilość potrzebnych danych do zapisania utworu może drastycznie zmaleć, przy wciąż jeszcze akceptowanej jakości. Cyfrowa reprezentacja umożliwia ponadto matematyczne filtrowanie (funkcja equalizer), regulację poziomu sygnału, miksowanie itp.

Kwantowanie wydaje się prostą operacją, ale niestety taka nie jest. Po pierwsze musimy sobie zadać pytanie: z jaką częstotliwością trzeba próbkować (pobierać próbki), żeby potem z wynikowych danych móc odtworzyć sygnał analogowy bez utraty jego jakości? Intuicyjnie czujemy, że powinno się to odbywać z jak najwyższą częstotliwością. Im więcej próbek, tym wierniej będą reprezentowały sygnał próbkowany.

Na rysunku 2 pokazano próbkowanie sygnału sinusoidalnego. Liczba próbek jest tak dobrana, że można z nich w przybliżeniu odtworzyć oryginalny sygnał. Im więcej będzie takich próbek, tym lepsze odwzorowanie. Takie postępowanie ma jednak sporą wadę: po pierwsze rośnie nam bardzo mocno ilość danych przeznaczonych do reprezentowania sygnału. Po drugie – nawet przy dużej liczbie próbek nie są one w stanie idealnie odtworzyć próbkowanego sygnału. Czyżby zatem cyfryzacja zapisu, która miała zapewnić bardzo dobrą jakość, z zasady powodowała zawsze zmianę kształtu przebiegu, a co za tym idzie – wprowadzała nieuchronne zniekształcenia harmoniczne? Na szczęście nie jest aż tak źle, ale powiemy o tym później.

Wróćmy do pytania o minimalną częstotliwość próbkowania. Wiemy, że jej zwiększanie nie spowoduje, że próbki będą reprezentowały ciągły sygnał. To oczywiste, bo próbkowanie zmienia naturę sygnału z ciągłego w dyskretny, to znaczy taki, w którym informacja o sygnale jest dostępna tylko w określonych interwałach czasowych. Pomiędzy tymi interwałami nie wiemy nic o jego kształcie. Dodajmy na marginesie, że innym znanym, dyskretnym przekształceniem sygnału ciągłego jest... przekształcenie Fouriera, w którym sygnał jest reprezentowany przez dyskretne poziomy amplitudy sygnału o częstotliwości podstawowej oraz jej harmonicznych.

Jako przykład weźmy sygnał sinusoidalny o częstotliwości f. Wykonajmy próbkowanie równomierne tego sygnału z różnymi częstotliwościami: 20 próbek na okres, 10 próbek na okres i 2 próbki na okres (rysunek 3). Wraz ze zmniejszeniem częstotliwości próbkowania kształt przebiegu (po interpolacji liniowej) coraz mniej przypomina oryginalną sinusoidę. Ale w każdym z tych przypadków można jeszcze zobaczyć okresowy charakter sygnału próbkowanego i określić jego częstotliwość. Nawet wtedy, gdy będą to tylko dwie próbki na okres.

A co się stanie, kiedy zmniejszymy liczbę próbek poniżej dwóch na okres? Na rysunku 4 pokazano próbkowanie z częstotliwością 1,1·f.

Nie dość, że nie możemy określić teraz częstotliwości próbkowanego sygnału, to proces próbkowania spowodował pojawienie się sygnału o znacznie niższej częstotliwości, której... nie było w oryginalnym przebiegu. Z analizy rysunków 3 i 4 możemy wysnuć luźne przypuszczenie, że częstotliwość próbkowania nie może być mniejsza niż 2 próbki na okres, gdyż tylko po spełnieniu tego warunku można określić częstotliwość oryginalnego zapisu. Poniżej tego progu próbki mogą reprezentować sygnały o zafałszowanych częstotliwościach, których nie ma w oryginalnym sygnale – co rzecz jasna nie powinno mieć miejsca.

W ten sposób dochodzimy do fundamentalnego, powszechnie znanego twierdzenia o próbkowaniu, które mówi, że częstotliwość próbkowania fs sygnału analogowego musi być przynajmniej dwukrotnie większa niż częstotliwość f0 sygnału próbkowanego. Możliwe jest wtedy idealne odtworzenie oryginalnego sygnału z zapisanych próbek.

Jeżeli częstotliwość próbkowania jest niższa, to taka operacja okazuje się niemożliwa do przeprowadzenia.

Twierdzenie o próbkowaniu było możliwe do sformułowania dzięki pracom kilku uczonych, głównie Harry’ego Nyquista, Claude'a Shannona, ale też Edmunda Whittakera czy Władimira Kotielnikowa.

Harry Nyquist jest być może znany Czytelnikom jako twórca teorii warunków stabilności wzmacniaczy ze sprzężeniem zwrotnym, ale nazwisko uczonego chyba znacznie częściej kojarzy się z kryterium Nyquista, dotyczącym właśnie minimalnej częstotliwości próbkowania sygnałów analogowych, przy której da się z próbek odtworzyć oryginalny sygnał bez zniekształceń.

Niejednoznaczność sygnału w dziedzinie częstotliwości

Dyskretne próbkowanie ciągłego sygnału ma pewną bardzo ważną właściwość. Załóżmy, że będziemy próbkować sygnał sinusoidalny z częstotliwością 4 próbek na okres. Takie próbkowanie spełnia warunek Nyquista, więc na podstawie skwantowanego zapisu możemy wykreślić oryginalny przebieg. Jednak kiedy poprosimy o to kogoś, kto nie zna oryginalnego przebiegu i nic o nim nie wie, to na podstawie tych próbek może wykreślić zupełnie inny przebieg, Taka możliwa sytuacja została pokazana na rysunku 5.

Jeżeli ciąg danych reprezentuje próbki przebiegu sinusoidalnego, to tylko na ich podstawie i bez dodatkowych informacji nie możemy określić jednoznacznie częstotliwości tego przebiegu.

Na rysunku 5 widać – wyznaczone na podstawie dostępnych próbek – dwa przebiegi sinusoidalne. Zadajmy sobie pytanie, czy faktycznie da się wykreślić tylko dwa? Otóż okazuje się, że można takich sygnałów wskazać… nieskończenie wiele!

Załóżmy, że przebieg sinusoidalny o częstotliwości f0 próbkujemy z częstotliwością fs. Jeżeli k jest dowolną liczbą całkowitą, to nie jesteśmy w stanie odróżnić (bazując tylko na podstawie próbek) przebiegu o częstotliwości f0 oraz sygnałów o sinusoidalnych o częstotliwościach f0 + k·fs, gdzie k – dowolna liczba całkowita.

Co to oznacza w praktyce? Okazuje się, że nie istnieje taki ciąg danych, który mógłby reprezentować jedną i tylko jedną sinusoidę. Żeby z takiego ciągu odtworzyć próbkowany przebieg, potrzebne są dodatkowe informacje. Z tego również wynika, że proces próbkowania „powiela” częstotliwość f0 do nieskończoności.

Powielanie widma, aliasing

Do tej pory ograniczyliśmy – dla wygody – nasze rozważania tylko do próbkowania pojedynczego sygnału sinusoidalnego o określonej częstotliwości. Rzeczywisty, ciągły sygnał audio jest jednak mieszanką różnych częstotliwości o charakterze dolnopasmowym. Przyjęło się, że widmo sygnału audio rozciąga się od 20 Hz do 20 kHz, ale my będziemy dla uproszczenia rozważać pasmo od 0 Hz do 20 kHz.

Analizowanie sygnałów audio w dziedzinie czasu jest dobre dla pojedynczego przebiegu sinusoidalnego, ale dla ciągłych sygnałów o ograniczonym paśmie dalsze rozważania wygodniej będzie przeprowadzać w dziedzinie częstotliwości. Żeby wyznaczyć widmo sygnału audio o charakterze dolnoprzepustowym, poddamy go przekształceniu Fouriera. Wiemy już, że częstotliwość graniczna wynosi fmax=20 kHz. Ciągłe widmo takiego sygnału zostało pokazane na rysunku 6.

Cała energia sygnału mieści się w zakresie od –fmax do +fmax, a poza tym zakresem jest równa zero.

Po spróbkowaniu sygnału o takim widmie otrzymamy dyskretne widmo sygnału próbkowanego o szerokości od –fmax do +fmax oraz szereg powielonych widm dyskretnych o takiej samej szerokości. Każde z nich jest przesunięte na osi częstotliwości o wartość k·fs. Zostało to pokazane na rysunku 7.

Możemy się zastanawiać, dlaczego te powielane widma stanowią potencjalne źródło problemów? Przecież interesują nas częstotliwości od –fmax do +fmax, a – jak widać na rysunku 7 – to widmo nie jest w żaden sposób modyfikowane. Żeby tak było w istocie, trzeba znać i prawidłowo stosować sposoby kontrolowania położenia powielanych widm na osi częstotliwości, właśnie za pomocą odpowiedniego doboru częstotliwości próbkowania. Jak się łatwo domyślić, kluczowym aspektem będzie kryterium Nyquista: fs>2·fmax. Jeżeli jest ono spełnione, to powielane widma nie zachodzą na widmo podstawowe, bo fmax<fs/2 – tak, jak to zostało pokazane na rysunku 8.

Warunek niezachodzenia na siebie powielonego widma i widma sygnału próbkowanego jest koniecznym warunkiem do idealnego odtworzenia sygnału analogowego z próbek, które utworzyliśmy w procesie próbkowania. Powiemy o tym jeszcze za chwilę.

Zobaczmy, jak będzie wyglądała sytuacja, gdy kryterium Nyquista nie zostanie spełnione – spójrzmy na rysunek 9. Widmo powielone zachodzi na widmo sygnału próbkowanego, powodując w rezultacie nieodwracalne zniekształcenia widma sygnału oryginalnego. To zjawisko nazywa się aliasingiem. Jeżeli w trakcie próbkowania powstanie aliasing, to nie mamy możliwości, żeby odtworzyć w przetworniku cyfrowo-analogowym sygnał oryginalny na podstawie zapisanych próbek. Jak już wspomniałem, opisywane zjawisko niszczy nieodwracalnie cyfrową reprezentację oryginalnego sygnału i musi być koniecznie wyeliminowane.

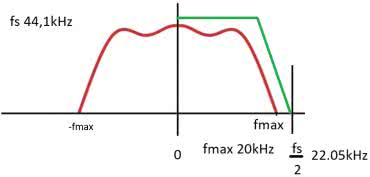

Podstawowy środek zapobiegawczy jest nam znany – wystarczy zastosować w praktyce kryterium Nyquista. Do sygnałów audio w paśmie ograniczonym do 20 kHz stosuje się dwie standardowe częstotliwości próbkowania: 44,1 kHz i 48 kHz. Teoretycznie powinno to wyeliminować problem aliasingu. Jednak w rzeczywistych układach nie istnieją idealne sygnały dolnoprzepustowe, w których powyżej fmax energia sygnału jest zerowa. W torach przesyłowych jest zawsze obecny szerokopasmowy szum. Częstotliwości tego szumu znacznie wykraczają poza częstotliwości graniczne fmax. Poza tym istnieje szereg zakłóceń radiowych bądź przewodzonych (z sieci energetycznej), które mogą być obecne w sygnale analogowym. Dlatego na wejściach przetworników analogowo-cyfrowych stosuje się dolnoprzepustowe filtry antyaliasingowe. Mają one za zadanie odfiltrowanie częstotliwości powyżej fmax.

Flitry antyaliasingowe

Analogowe filtrowanie antyaliasingowe jest dość trudne w realizacji. Jeżeli przyjmiemy, że fmax jest równa 20 kHz, a fs ma wartość 44,1 kHz, to filtr powinien przenosić bez zniekształceń częstotliwość 20 kHz i całkowicie tłumić częstotliwość 22,05 kHz (fs/2). Wykonanie takich filtrów jest technicznie kłopotliwe, a na pewno skomplikowane i drogie. Na stronie firmy Microchip można znaleźć kreator filtrów analogowych FilterLab pracujący on-line i wykonać proste ćwiczenie symulacji projektu filtra dolnoprzepustowego, który będzie przenosił pasmo 20 kHz ze spadkiem –3dB. Wybrałem filtr Czebyszewa 8. rzędu w topologii Sallena–Keya. Schemat filtra został pokazany na rysunku 10, a jego charakterystyka amplitudowa – na rysunku 11.

Filtr Czebyszewa charakteryzuje się szybkim wzrostem tłumienia w pasmie zaporowym, ale niestety wprowadza zafalowania charakterystyki w pasmie przepustowym. Jeżeli będziemy próbkować sygnał o szerokości widma 20 kHz z częstotliwością fs=44,1 kHz, to przy częstotliwości fs/2 tłumienie naszego filtra będzie równe ok. –27 dB. Jeżeli próbkowany sygnał będzie miał duży poziom zakłóceń powyżej 20 kHz, to nawet taki filtr nie zapewni odpowiedniego tłumienia zjawiska aliasingu.

Na pierwszy rzut oka wydawałoby się, że może w dużych studiach nagraniowych nie stanowiłoby problemu zastosowanie skomplikowanych i rozbudowanych filtrów o odpowiednich parametrach, zapewniających bardzo niski poziom aliasingu. Jednak znaleziono dużo lepszy sposób na pozbycie się aliasingu niż rozbudowane filtry analogowe na wejściu przetworników analogowo cyfrowych.

Nadpróbkowanie (oversampling) w konwersji analogowo cyfrowej

Na rysunku 12 pokazano typową sytuację spotykaną w technice audio. Sygnał analogowy o pasmie 20 kHz jest próbkowany z częstotliwością 44,1 kHz. Żeby wyeliminować aliasing, w sygnale analogowym muszą być odfiltrowane wszystkie częstotliwości powyżej fs/2, czyli 22,05 kHz. Na wykresie pasma zaznaczono wymaganą charakterystykę filtru dolnoprzepustowego.

Jak już wiemy, implementacja takiego filtru jest trudna pod względem technicznym. Kryterium Nyquista nakłada na nas konieczność próbkowania z częstotliwością nie mniejszą niż 2·fmax – możemy więc z powodzeniem próbkować z częstotliwościami większymi. Zobaczmy co się stanie, gdy będziemy rejestrować sygnał z częstotliwością dwa razy większą, niż wynikająca z kryterium Nyquista. Powielone pasma na osi częstotliwości będą rozmieszczone nie co wartość fs, ale co 2·fs – tak jak to zostało pokazane na rysunku 13.

Nadpróbkowanie to proces polegający na zwielokrotnianiu częstotliwości próbkowania wynikającej z kryterium Nyquista. W naszym przykładzie pasmo analogowe jest nadal ograniczone do 20kHz, ale próbkujemy je z częstotliwością nie 44,1 kHz, ale 88,2 kHz. W efekcie takiej operacji pierwsze powielone pasmo zaczyna się dużo dalej od końca pasma podstawowego. Co nam to daje? Filtr dolnopasmowy musi tłumić nie do 22,05 kHz, tylko fs/2, czyli do 44,1 kHz. Taki filtr jest już dużo łatwiejszy do wykonania.

No dobrze, nadpróbkowanie eliminuje paskudny problem ze skomplikowanym filtrem antyaliasingowym, ale generuje kolejny kłopot. Jeżeli próbkujemy sygnał z częstotliwością wielokrotnie większą niż wymagana do idealnego odtworzenia sygnału z próbek, to mamy mnóstwo nadmiarowych próbek, które w istocie... nie są do niczego potrzebne. W praktyce przydałyby się one w trakcie konwersji cyfrowo-analogowej, bo tam będzie lustrzany problem z powielaniem pasm, tylko już w domenie analogowej, a nie w dyskretnej. Ale konwersja C/A poradzi sobie i bez tego, a nadmiarowa ilość danych z konwersji analogowo-cyfrowej bardzo komplikuje ich zapisywanie i przesyłanie.

Decymacja (downsampling)

Technika cyfrowa radzi sobie z tym problemem za pomocą operacji decymacji. Decymacja to zachowanie co n-tej próbki i odrzucenie pozostałych ze zbioru nadpróbkowanych danych – bez szkody dla informacji, z których będziemy odtwarzać później sygnał analogowy. Przykładowo: w przypadku dwukrotnego napróbkowania zachowujemy jedynie co druga próbkę.

Zastanówmy się jednak nad pewną kwestią. Dwukrotnie nadpróbkowane dane reprezentują sygnał o dwa razy szerszym paśmie: w naszym przypadku nie 20 kHz, a 40 kHz (a dokładniej 44,1 kHz). Wykonanie decymacji będzie znowu przesuwało powielone widmo w kierunku niższych częstotliwości, co poskutkuje ponownym pojawieniem się aliasingu, którego przecież chcieliśmy uniknąć zwiększając częstotliwość próbkowania. Żeby poradzić sobie z tym problemem, trzeba najpierw dane przefiltrować dolnoprzepustowym filtrem cyfrowym (aby próbki ponownie reprezentowały sygnał o paśmie pierwotnego sygnału analogowego). Dopiero po tym poddajemy je decymacji.

Jednak te operacje, w odróżnieniu do rozbudowanych filtrów analogowych, można wykonać bez problemu w scalonych przetwornikach analogowo-cyfrowych – już za miesiąc przyjrzymy bliżej temu zagadnieniu.

Tomasz Jabłoński, EP

Zaloguj

Zaloguj